🗣 SL提问: ai聊天怎么训练

✍️ Ai批改: 训练AI聊天机器人通常涉及几个步骤,包括数据收集、模型选择、训练和测试。以下是训练AI聊天的一般流程:

1、数据收集

数据源:收集大量文本数据,这些数据将作为训练的基础。这些数据可以来自多种来源,如书籍、文章、网站、社交媒体等。

数据预处理:清理和预处理数据,去除不相关的信息,纠正错误,统一格式等。

2、选择合适的模型

选择模型:根据任务的需求选择合适的自然语言处理(NLP)模型。常见的模型包括但不限于:

循环神经网络(RNN):特别是在处理序列数据时非常有效。

长短期记忆网络(LSTM):RNN的一种变体,更适合处理长序列数据。

Transformer:近年来特别流行的模型,特别适合处理序列到序列的任务,如翻译、摘要等。

预训练语言模型:如BERT、RoBERTa等,这些模型通过在大规模文本数据集上进行预训练,能够学习到丰富的语言特征。

3、模型训练

训练数据集:将预处理好的数据分成训练集和验证集。训练集用于模型的训练,验证集用于调整模型的参数和评估模型的性能。

定义任务:根据聊天机器人的目的定义具体任务,如问答系统、闲聊机器人等。

训练模型:使用训练集对模型进行训练。在这个过程中,模型会学习数据的模式和关系。

4、模型评估和调整

评估指标:使用验证集来评估模型的性能。不同的任务可能需要不同的评估指标,如准确率、召回率、F1分数、BLEU分数等。

超参数调优:调整模型的超参数(如学习率、批次大小等)以优化模型性能。

5、测试和部署

测试集评估:使用独立的测试集对训练好的模型进行最终评估,确保模型在未知数据上的表现。

部署:将训练好的模型部署到实际应用中。

6、持续学习和更新

收集反馈:在实际应用中收集用户反馈,根据反馈调整和更新模型,以提高其性能和适应性。

训练AI聊天机器人示例代码(简)

以下是一个使用Python和Hugging Face的Transformers库训练一个简单聊天机器人的示例:

python

from transformers import AutoModelForSeq2SeqLM, AutoTokenizer

from torch.utils.data import Dataset, DataLoader

import torch

假设你有一个数据集,其中包含了问答对

class ChatDataset(Dataset):

def __init__(self, data, tokenizer):

self.data = data

self.tokenizer = tokenizer

def __len__(self):

return len(self.data)

def __getitem__(self, idx):

input_text = self.data[idx]['input']

output_text = self.data[idx]['output']

encoding = self.tokenizer.encode_plus(

input_text,

add_special_tokens=True,

max_length=512,

return_attention_mask=True,

return_tensors='pt',

truncation=True,

padding='max_length'

)

decoding = self.tokenizer.encode_plus(

output_text,

add_special_tokens=True,

max_length=512,

return_attention_mask=False,

return_tensors='pt',

truncation=True,

padding='max_length'

)

return {

'input_ids': encoding['input_ids'].flatten(),

'attention_mask': encoding['attention_mask'].flatten(),

'labels': decoding['input_ids'].flatten(),

}

加载预训练模型和分词器

model_name = t5-small

model = AutoModelForSeq2SeqLM.from_pretrained(model_name)

tokenizer = AutoTokenizer.from_pretrained(model_name)

创建数据集和数据加载器

dataset = ChatDataset(your_data, tokenizer)

data_loader = DataLoader(dataset, batch_size=16, shuffle=True)

训练

device = torch.device(cuda if torch.cuda.is_available() else cpu)

model.to(device)

for epoch in range(5): 训练5个epoch

model.train()

for batch in data_loader:

input_ids = batch['input_ids'].to(device)

attention_mask = batch['attention_mask'].to(device)

labels = batch['labels'].to(device)

optimizer = torch.optim.Adam(model.parameters(), lr=1e-5)

optimizer.zero_grad()

outputs = model(input_ids, attention_mask=attention_mask, labels=labels)

loss = outputs.loss

loss.backward()

optimizer.step()

print(f'Epoch {epoch+1}, Loss: {loss.item()}')

保存模型

torch.save(model.state_dict(), 'chat_model.pth')

这是一个非常简化的示例,实际的训练过程可能需要根据具体任务和数据进行调整。

0

IP地址: 251.134.171.199

搜索次数: 11

提问时间: 2025-04-20 23:40:44

❓️ 热门提问:

福州收购黄金的地方

黄金的颜色值

ai聊天套路

18k金 四叶草项链

人民银行外汇卖出价

ai人工智能变瘦

79年外汇兑换券

去域名查询

小熊推金币2破解版

国外的珠宝品牌

豌豆Ai站群搜索引擎系统

🤝 关于我们:

三乐Ai

作文批改

英语分析

在线翻译

拍照识图

Ai提问

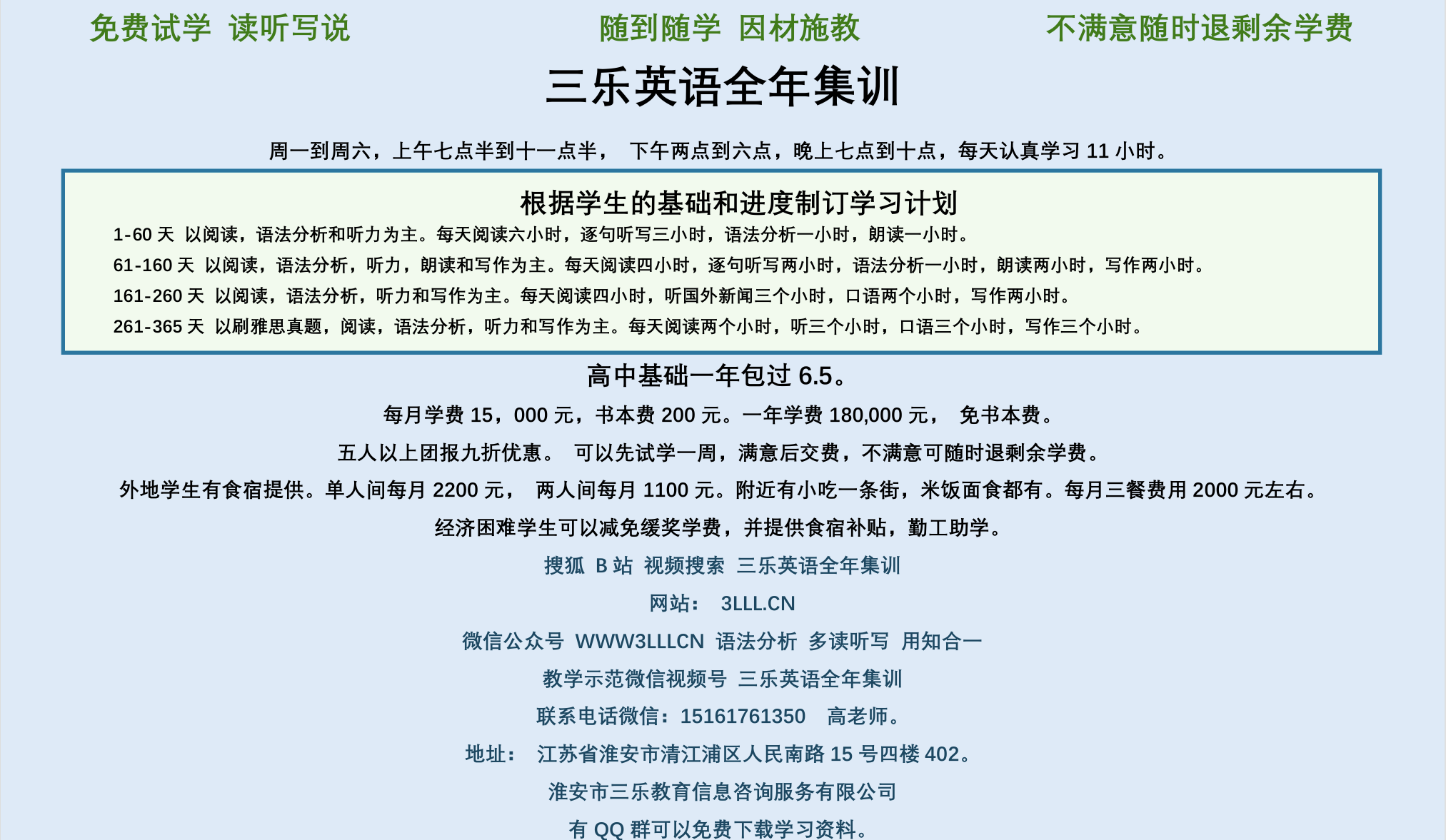

英语培训

本站流量

联系我们

🔗 友情链接:

Search website

月饼

ai提问

📢 温馨提示:本站所有问答由Ai自动创作,内容仅供参考,若有误差请用“联系”里面信息通知我们人工修改或删除。

👉 技术支持:本站由豌豆Ai提供技术支持,使用的最新版:《豌豆Ai站群搜索引擎系统 V.25.05.20》搭建本站。